Efekt potwierdzenia

Efekt potwierdzenia, błąd konfirmacji, strategia konfirmacyjna – tendencja do preferowania informacji, które potwierdzają wcześniejsze oczekiwania i hipotezy, niezależnie od tego, czy te informacje są prawdziwe[1]. Powoduje, że ludzie poszukują informacji i zapamiętują je w sposób selektywny, interpretując je w błędny sposób. Efekt ten jest szczególnie silny w przypadku zagadnień wywołujących silne emocje i dotyczących mocno ugruntowanych opinii. Przykładowo, czytając o polityce dostępu do broni, ludzie zwykle preferują źródła, które potwierdzają to, co sami na ten temat sądzą. Mają również tendencję do interpretowania niejednoznacznych dowodów jako potwierdzających ich własne zdanie.

Selektywne poszukiwanie informacji, ich zapamiętywanie i interpretowanie jest przytaczane jako wytłumaczenie efektu polaryzacji przekonań (gdy różnica zdań staje się jeszcze większa po zaprezentowaniu dwóm stronom tych samych dowodów), trwałości przekonań (gdy przekonania pozostają niezmienione nawet po obaleniu dowodów, z których wynikały), efektu pierwszeństwa (gdy większa waga przykładana jest do informacji, które uzyskało się wcześniej) i iluzji korelacji (doszukiwania się korelacji tam, gdzie ich w rzeczywistości nie ma).

Serie eksperymentów prowadzonych w latach 60. XX wieku pokazały, że ludzie mają tendencję do poszukiwania potwierdzeń dla swoich wcześniejszych przeświadczeń. Późniejsze badania wyjaśniły to jako wynik tendencji do testowania hipotez bardzo selektywnie, skupiając się na jednej możliwości i ignorując alternatywy. W połączeniu z innymi efektami taka strategia wpływa na konkluzje, do jakich ludzie dochodzą. Błąd ten może wynikać z ograniczonych możliwości przetwarzania informacji przez ludzki mózg lub z ewolucyjnej optymalizacji, gdy szacowane koszty tkwienia w błędzie nie są większe niż koszty analizy prowadzonej w obiektywny, naukowy sposób.

Efekt potwierdzenia wzmacnia pewność siebie i pozwala ludziom zachować silne przekonania nawet w obliczu przeczących im dowodów. Dlatego może prowadzić do katastrofalnych błędów w podejmowaniu decyzji, w szczególności w przypadku decyzji społecznych, politycznych i militarnych.

Typy

Efekt potwierdzenia należy do grupy błędów poznawczych dotyczących przetwarzania informacji, w odróżnieniu od błędów w zachowaniu polegających na tym, że ludzie zachowują się tak, żeby ich oczekiwania się spełniły[2]. Niektórzy psychologowie używają pojęcia efektu potwierdzenia wszędzie tam, gdzie ludzie w jakiś sposób unikają pozbycia się jakiegoś przeświadczenia, zarówno przy poszukiwaniu faktów, interpretowaniu ich albo przypominaniu ich sobie. Inni odnoszą to pojęcie jedynie do selektywnego poszukiwania informacji[3]. W odniesieniu do niewłaściwego interpretowania dowodów używane jest też pojęcie błędu asymilacji[4].

Błędy w poszukiwaniu informacji

Wiele eksperymentów pokazało, że ludzie mają tendencję do testowania swoich hipotez jednostronnie, przez poszukiwanie wyłącznie dowodów potwierdzających je[6][7]. Zamiast sprawdzać wszystkie możliwości, zadają pytania tak, aby odpowiedź twierdząca potwierdzała to, co założyli[8]. Poszukują jedynie skutków, jakie wystąpiłyby, gdyby była prawdziwa, ignorując potencjalne skutki, które powodowałaby jej fałszywość[8]. Przykładowo, jeśli ktoś ma zidentyfikować ukrytą liczbę przy użyciu jedynie pytań, na które odpowiedź może być tak albo nie i podejrzewa, że odpowiedzią jest 3, może zadać pytanie: Czy to jest liczba nieparzysta?, ale prawie nigdy nie zada pytania: Czy to jest liczba parzysta? – mimo że uzyskałby w ten sposób tę samą informację[9]. Nie oznacza to, że ludzie świadomie preferują pytania, które gwarantują odpowiedź twierdzącą. W badaniach, w których mogą wybierać pomiędzy zaproponowanymi pytaniami jednostronnymi i obiektywnymi, częściej wybierają obiektywne[10][11].

Samo preferowanie jednostronnych pytań nie musi być błędem, jeśli pytania prowadzą do uzyskania pełnej informacji[12]. Jednak w połączeniu z innymi efektami taka strategia prowadzi do utwierdzenia się w swoich przeświadczeniach, niezależnie od tego, czy są one prawdziwe[13][14]. W rzeczywistym świecie dowody są często skomplikowane i wieloaspektowe. Przykładowo różne czyny dokonane przez jedną osobę mogą stanowić potwierdzenie dla wielu różnych, sprzecznych ze sobą, opinii o tej osobie[7]. Dlatego każdy, kto szuka uzasadnienia dla swojej opinii, może znaleźć fakty będące takim uzasadnieniem[13]. Dodatkowo, sam sposób formułowania pytań może znacząco wpłynąć na uzyskiwane odpowiedzi[7]. Przykładowo gdy ludziom zadaje się pytanie: Czy jesteś zadowolony ze swoich kontaktów towarzyskich? otrzymuje się bardziej pozytywne informacje, niż gdy zadaje im się pytanie Czy jesteś niezadowolony ze swoich kontaktów towarzyskich[15]? (porównaj pytanie sugerujące).

Nawet niewielka zmiana w sposobie sformułowania pytania może wpłynąć na to, jak ludzie na nie odpowiadają. Zostało to pokazane w fikcyjnej sprawie o prawo do opieki nad dzieckiem[16]. Badani dostali informację, że Rodzic A jest przeciętnie odpowiedni do opieki. Rodzic B został opisany przez mieszaninę cech odpowiednich, jak i nieodpowiednich do opieki: bliskie kontakty z dzieckiem oraz czasochłonną pracę, która oznaczałaby długie okresy rozłąki z dzieckiem. Ci badani, których pytano: Który rodzic powinien otrzymać prawa do opieki? zwracali uwagę na pozytywne cechy Rodzica B i wskazywali na niego. Ci badani, których pytano: Który rodzic nie powinien otrzymać praw do opieki? zwracali uwagę na negatywne cechy Rodzica B i również wskazywali na niego, implikując, że opieka powinna zostać przyznana Rodzicowi A[16].

Podobne badania pokazały, że ludzie poszukują informacji w sposób jednostronny, ale że świadomie preferują testy dające więcej informacji, jeśli takie są dostępne. W przykładowym eksperymencie badani mieli ocenić, czy inna osoba jest introwertykiem czy ekstrawertykiem na podstawie krótkiej rozmowy. Mogli zadawać pytania z udostępnionej im listy. Gdy osoba, którą mieli ocenić, była opisywana jako introwertyczna, wybierali pytania zakładające tę wersję, takie jak: Co cię najbardziej męczy na hałaśliwych przyjęciach? Gdy osoba była opisywana jako ekstrawertyczna, zadawali pytania zakładające tę wersję, takie jak: Co zrobisz, żeby ożywić nudne przyjęcie? Te pytania sprawiały, że odpowiadający mieli niewielką możliwość obalenia pierwotnie założonej opinii[17]. W późniejszej wersji eksperymentu dano badanym do wyboru bardziej neutralne pytania, takie jak Czy jesteś nieśmiały w kontaktach towarzyskich?[18] Badani preferowali wtedy te pytania, w niewielkim tylko stopniu preferując takie, co do których liczyli na odpowiedź twierdzącą. Ten wzorzec wybierania pytań bardziej diagnostycznych przy niewielkiej preferencji dla poszukiwania odpowiedzi twierdzących był potwierdzany również w innych badaniach[18].

W innym eksperymencie badani mieli odtworzyć skomplikowane reguły rządzące poruszaniem się obiektów na ekranie komputera[19]. Badani mogli „strzelać” obiektami po ekranie i obserwować ich zachowanie. Mimo wielu prób żadnemu z badanych nie udało się odtworzyć poszukiwanych reguł. Zwykle próbowali tylko potwierdzić swoje pierwotne hipotezy i niechętnie poszukiwali alternatyw. Nawet wielokrotnie widząc, że obiekty nie poruszają się zgodnie z założonymi przez nich hipotezami, powtarzali te same testy. Niektórzy z badanych otrzymali instrukcję, w jaki sposób należy falsyfikować hipotezy, ale nie miało to prawie żadnego efektu[19].

Błędy w interpretowaniu informacji

„Inteligentni ludzie wierzą w dziwne rzeczy, ponieważ potrafią inteligentnie bronić swoich przekonań, które uzyskali w mało inteligentny sposób”.

Efekt potwierdzenia nie ogranicza się tylko do błędów w zbieraniu informacji. Nawet jeśli dwie osoby otrzymają tę samą informację, mogą ją interpretować w różny sposób.

Zespół badawczy ze Stanford University przeprowadził serię eksperymentów, w których uczestniczyli badani o ugruntowanym zdaniu na temat kary śmierci. Połowa badanych była jej silnymi zwolennikami, a połowa zdecydowanymi przeciwnikami[21][22]. Każdemu z badanych dano do przeczytania opis dwóch badań: porównania wskaźników przestępczości w stanach z wprowadzoną i z zakazaną karą śmierci oraz porównania wskaźników przestępczości przed i po wprowadzeniu kary śmierci. Po ich przeczytaniu badani byli pytani, czy ich opinie się zmieniły. Potem dano im do przeczytania bardziej szczegółowe dane dotyczące procedur przeprowadzenia tych badań i poproszono o ocenę tego, jak dobrze według nich były przeprowadzone i jak wiarygodne[21]. W rzeczywistości wszystkie te badania były sfabrykowane. Połowie badanych powiedziano, że pierwsze badanie wskazuje na skuteczność kary śmierci, a drugie na jej nieskuteczność. Drugiej połowie badanych powiedziano na odwrót[21][22].

Badani, zarówno zwolennicy, jak i przeciwnicy, początkowo nieznacznie zmienili swoje opinie w stronę sugerowaną przez pierwsze badanie. Gdy przeczytali dokładny opis procedur tych badań, niemal wszyscy powrócili do swoich pierwotnych opinii, niezależnie od zaprezentowanych im dowodów. Uzasadniali to, wskazując elementy badania zgodne z ich opinią i ignorując wszystkie przeczące jej. Przy ocenie jakości badania określili badanie potwierdzające ich opinię jako znacznie bardziej wiarygodne i lepiej przeprowadzone, szczegółowo to uzasadniając[21][23]. Opisując badanie, którego wyniki podważały ich opinię, zwolennicy kary śmierci napisali: Badanie nie objęło wystarczająco długiego okresu. Przeciwnicy kary śmierci o tym samym badaniu napisali: Nie przedstawiono żadnych dowodów przeczących wnioskom badaczy[21]. Wyniki pokazały, że ludzie stawiają znacznie większe wymagania hipotezom, które miałyby podważyć ich oczekiwania. Ten efekt, nazwany „błędem falsyfikacji”, został potwierdzony w innych eksperymentach[24].

W trakcie wyborów prezydenckich w USA w 2004 roku przeprowadzono serię badań nad błędnym interpretowaniem informacji przez wyborców. Uczestniczyli w nich badani o wyrobionych opiniach o kandydatach. Zaprezentowano im pary wypowiedzi każdego z kandydatów, które wyglądały na sprzeczne ze sobą. Następnie każdemu z nich zaprezentowano wyjaśnienia, które uściślały te wypowiedzi i pokazywały, że nie są one ze sobą sprzeczne. Badani mieli określić, czy wypowiedzi faktycznie przeczą sobie nawzajem. Pokazano, że badani znacznie częściej oceniali jako wewnętrznie sprzeczne wypowiedzi kandydata, którego nie popierali[25].

W trakcie tego eksperymentu badani znajdowali się w skanerze MRI, który monitorował pracę ich mózgu. Gdy badani oceniali wypowiedzi popieranego przez nich kandydata, ośrodki odpowiedzialne za emocje były bardzo aktywne. Nie występowało to, gdy oceniali wypowiedzi drugiego z kandydatów. Badacze wywnioskowali z tego, że różne oceny wypowiedzi kandydatów nie wynikały z błędów w rozumowaniu, ale z aktywnego redukowania dysonansu poznawczego powodowanego przez nieracjonalność albo hipokryzję popieranego przez nich kandydata[25].

Błędy w interpretowaniu informacji nie ograniczają się tylko do emocjonalnie nacechowanych tematów. W innym eksperymencie badanym przedstawiono historię o kradzieży. Mieli za zadanie ocenić istotność zeznań obciążających bądź oczyszczających podejrzanego. Gdy sami podejrzewali, że jest on winny, oceniali zeznania obciążające go za bardziej istotne, niż zeznania oczyszczające go z zarzutów[26].

Błędy w zapamiętywaniu

Nawet jeśli ktoś poszukuje i interpretuje informacje w sposób obiektywny, wciąż może ulegać efektowi selektywnej pamięci, potwierdzając swoje oczekiwania. Efekt ten jest nazywany „selektywnym przypominaniem”, „pamięcią potwierdzającą”, albo „pamięcią o nierównym dostępie”[27]. Istnieją różne wytłumaczenia tego efektu. Z jednej strony psychologowie postulują, że informacje pasujące do jednej opinii tworzą schemat poznawczy, dzięki czemu są łatwiej zapamiętywane i przypominane[28]. Z drugiej strony istnieją teorie, że zaskakujące informacje wyróżniają się i przez to łatwiej je zapamiętać[28]. Oba te efekty zostały potwierdzone eksperymentalnie i obecnie nie ma jednoznacznego rozstrzygnięcia, który jest silniejszy[29].

W jednym z eksperymentów badani czytali opis kobiety, zawierający mieszaninę zachowań introwertycznych i ekstrawertycznych[30]. Następnie po jakimś czasie mieli przypomnieć sobie zachowania świadczące o jej introwertyzmie albo ekstrawertyzmie. Części badanych powiedziano wcześniej, że mają ocenić, czy kobieta ta nadaje się na stanowisko bibliotekarki, a pozostałym, czy nadaje się na stanowisko agenta nieruchomości. Pokazano wyraźne różnice w tym, co byli sobie w stanie przypomnieć badani. Grupa oceniająca na stanowisko bibliotekarki przypominała sobie więcej zachowań introwertycznych, a grupa oceniająca na stanowisko agenta nieruchomości więcej zachowań ekstrawertycznych[30].

Efekt selektywnej pamięci pokazano również w eksperymentach, w których manipulowano zaletami różnych typów osobowości[28][31]. W jednym z takich eksperymentów pokazano badanym dowody, że ludzie ekstrawertyczni osiągają większe sukcesy niż introwertyczni. Innym badanym pokazano dowody wskazujące na coś przeciwnego. Następnie, w rzekomo niezwiązanym badaniu, badani mieli przypomnieć sobie przykłady swojego zachowania, które świadczyłoby o ich własnym introwertyzmie lub ekstrawertyzmie. Każda grupa przypomniała sobie więcej zachowań wskazujących na pożądane zachowanie i przypominała je sobie szybciej[32].

W innym badaniu pokazano, jak wybiórcza pamięć może podtrzymywać wiarę w postrzeganie pozazmysłowe (ESP)[33]. Wierzącym i niewierzącym w ESP pokazano opisy badań nad tym zjawiskiem. Połowie każdej grupy powiedziano, że wyniki eksperymentów potwierdziły istnienie ESP, a połowie, że nie potwierdziły. Po jakimś czasie badani mieli przypomnieć sobie szczegóły tych eksperymentów. W większości badani potrafili je sobie przypomnieć ze szczegółami. Wyjątkiem byli ci wierzący w ESP, którym powiedziano, że eksperymenty nie potwierdziły istnienia ESP. Zapamiętali oni wyraźnie mniej szczegółów, a część z nich nieprawidłowo zapamiętała, że eksperymenty potwierdziły istnienie ESP[33].

Powiązane efekty

Polaryzacja poglądów

Gdy zwolennicy dwóch przeciwstawnych opinii interpretują te same fakty w nieprawidłowy sposób, ich opinie mogą stać się jeszcze bardziej radykalne. Efekt ten nazywany jest „polaryzacją poglądów”[34]. Został on pokazany w eksperymencie, w którym badani mieli odgadnąć, z którego worka pochodzi losowa sekwencja czarnych i czerwonych kul. Badani wiedzieli, że w pierwszym worku jest 60% kul czarnych i 40% czerwonych, a w drugim 40% czarnych i 60% czerwonych. Naukowcy badali, co się dzieje, gdy badanym prezentowano na zmianę czerwone i czarne kule – sekwencję, która z równym prawdopodobieństwem mogła pochodzić z każdego z worków. Po każdej zaprezentowanej kuli badani mieli głośno powiedzieć, jakie jest według nich prawdopodobieństwo, że kule pochodzą z worka pierwszego, a jakie, że z drugiego. Pokazano, że zarówno ci, którzy początkowo sądzili, że kule pochodzą z pierwszego worka, jak i ci, którzy sądzili, że z drugiego, w miarę prezentowania kolejnych kul coraz bardziej upewniali się w swojej opinii. Inną grupę badanych poproszono o określenie prawdopodobieństwa dopiero po obejrzeniu całej sekwencji zamiast po każdej kolejnej kuli. U tych badanych efekt polaryzacji nie wystąpił, co mogło sugerować, że efekt ten nie musi wynikać z samego posiadania jakiejś opinii, ale raczej z otwartego przyznawania się do niej[35].

Na Uniwersytecie Stanforda przeprowadzono badanie polaryzacji poglądów na tematy, które wywołują silne emocje: polityki dostępu do broni oraz akcji afirmatywnej[24]. Badani określali swoje podejście do tych tematów przed i po przeczytaniu argumentacji dwóch spierających się stron. U dwóch grup stwierdzono polaryzację poglądów: u badanych o silnej pierwotnej opinii oraz u badanych o dużej wiedzy politycznej. Część badania polegała na tym, że badani sami wybierali, jakie opracowania chcą przeczytać. Przykładowo mogli wybierać pomiędzy opracowaniami przygotowanymi przez National Rifle Association albo przez kampanię przeciwników powszechnego dostępu do broni. Nawet gdy badani byli instruowani, aby rozważyć sprawę obiektywnie, częściej sięgali po opracowania potwierdzające ich punkt widzenia[24].

Utrzymywanie się przeświadczeń

„Wierzenia mogą przetrwać potężne logiczne i empiryczne wyzwania. Mogą przetrwać albo nawet zostać wzmocnione przez dowody, co do których większość postronnych obserwatorów zgodnie uzna, że logicznie wymagają pewnego osłabienia tych wierzeń. Mogą nawet przetrwać całkowite zniszczenie dowodów, z których pierwotnie powstały (efekt uporczywości)”.

Efekt potwierdzenia może zostać użyty do wyjaśnienia, czemu niektóre przeświadczenia pozostają, nawet jeśli fakty, z których wynikły, zostaną obalone[37]. Ten efekt utrzymywania się przeświadczeń został zaprezentowany w serii doświadczeń, w których badani zapoznawali się z dowodami potwierdzającymi jakąś hipotezę, mierzono zmianę ich opinii, a następnie wyjaśniano im, że zaprezentowane dowody były fikcyjne. Potem mierzono ponownie zmianę ich opinii[36].

W większości takich badań pokazywano, że badanym pozostawała po eksperymencie przynajmniej częściowa wiara w prawdziwość hipotezy[38]. Przykładowo w jednym z eksperymentów badani mieli za zadanie odróżnić prawdziwy list samobójczy od fałszywego. Losowo wybranym badanym powiedziano, że dokonali tego dobrze, a pozostałym, że źle. Mierzono, jak oceniają swoje umiejętności w wykonaniu tego zadania. Nawet gdy powiedziano im później, że ocena była przyznana losowo, badani wciąż w większości oceniali swoje umiejętności zgodnie z tym, jak zostali ocenieni[39].

W innym eksperymencie badani czytali ocenę rezultatów pracy dwóch strażaków razem z wynikami ich testów skłonności do ryzyka[36]. Były one spreparowane tak, żeby pokazać pozytywną albo negatywną korelację skłonności do ryzyka z odnoszeniem sukcesów[40]. Nawet jeśli byłyby opracowane na podstawie rzeczywistych danych, byłyby słabą podstawą do doszukiwania się związku. Badani jednak uznawali je często za bardzo przekonujące[40]. Kiedy ujawniano badanym, że zaprezentowane oceny były spreparowane, ich przekonanie co do istnienia dowodzonego związku zmniejszyło się, ale nie zniknęło całkowicie. Dalsze rozmowy z badanymi pozwoliły ustalić, że zrozumieli oni cały scenariusz badania i wiedzieli, że dane, jakie im zaprezentowano, były fikcyjne, ale uznawali, że ich własna opinia nie zmieniła się pod ich wpływem[40].

Preferowanie wcześniejszych informacji

Eksperymenty pokazały, że informacje, które pojawiają się wcześniej w serii, są traktowane jako istotniejsze niż te, które pojawiają się później. Przykładowo, ludzie oceniają lepiej osobę opisaną jako „inteligentna, przedsiębiorcza, impulsywna, krytyczna, uparta i zazdrosna”, niż opisaną tymi samymi słowami, ale podanymi w odwrotnej kolejności[41]. Efekt potwierdzenia tłumaczy to faktem, że po przeczytaniu pierwszych słów ludzie podświadomie formułują wstępną opinię, która wpływa na interpretowanie kolejnych informacji[37].

W przykładowym eksperymencie, badanym prezentowano na ekranie kolejne zdjęcia jakiegoś obiektu, zaczynając od bardzo rozmazanych i stopniowo poprawiając ich ostrość[41]. Po każdym zaprezentowanym zdjęciu badani mieli powiedzieć, co według nich znajduje się na zdjęciu. Ci, którzy początkowo odgadli nieprawidłowo, utrzymywali swoje przeświadczenie przez kilka kolejnych zdjęć, nawet jeśli były one na tyle wyraźne, że osoba postronna nie miała problemów z poprawnym rozpoznaniem znajdującego się na nich obiektu[37].

Iluzja korelacji

Iluzja korelacji to tendencja do dostrzegania nieistniejących korelacji w jakimś zbiorze danych[42]. Została ona po raz pierwszy pokazana w serii eksperymentów w latach 60. XX wieku[43]. W jednym z nich badanym dano do przeczytania opisy przypadków psychiatrycznych wraz z wynikami testu Rorschacha pacjentów. Badani zauważyli, że w tych testach homoseksualni pacjenci częściej dostrzegali pośladki, odbyty i seksualne kształty. W rzeczywistości opisy były spreparowane i w jednej wersji nawet specjalnie zebrane w ten sposób, żeby homoseksualni pacjenci rzadziej mieli takie wyniki testów[42]. W jednym z badań psychoanalitycy dostrzegli tę samą iluzję korelacji z homoseksualnością[43][42].

W innym eksperymencie badano chorych na artretyzm, porównując ich objawy z warunkami pogodowymi. Niemal wszyscy pacjenci twierdzili, że napady choroby były skorelowane z pogodą, choć w rzeczywistości żadnej korelacji nie było[44].

Ten efekt jest przykładem nieprawidłowego interpretowania informacji, w którym niejednoznaczne bądź nawet niesprzyjające informacje są używane jako potwierdzenie założonej hipotezy[45]. Oceniając, czy jakieś dwa zjawiska, jak np. napad choroby i pogorszenie pogody, są ze sobą powiązane, ludzie często biorą pod uwagę głównie liczbę przypadków „podwójnie pozytywnych”: w tym przykładzie takich, gdzie występuje jednocześnie napad choroby i zła pogoda. Ignorują przy tym pozostałe kombinacje[46]. Jest to powiązane z jednostronnym testowaniem hipotez[45], jak również z selektywną pamięcią, ponieważ ludzie łatwiej pamiętają sytuacje, gdy dwa zjawiska zachodzą jednocześnie[45]. Może to prowadzić do zupełnie błędnych wniosków.

| Dni | Deszcz | Brak deszczu |

|---|---|---|

| Artretyzm | 14 | 6 |

| Brak artretyzmu | 7 | 2 |

W powyższym fikcyjnym przykładzie symptomy artretyzmu występują częściej przy ładnej pogodzie (75%) niż przy deszczowej (66%). Jednak większa liczba dni deszczowych sprawia, że więcej jest dni, gdy występuje zarówno deszcz, jak i artretyzm. Osoba, która koncentruje się na jednej tylko komórce tej tabeli, może nieprawidłowo stwierdzić, że deszcz wiąże się z objawami artretyzmu[47].

Historia

Nieformalne obserwacje

Zanim psychologowie zaczęli badać efekt potwierdzenia naukowymi metodami, był on dostrzegany przez różnych pisarzy, w tym greckiego historyka Tukidydesa (460–393 p.n.e.), włoskiego poetę Dante Alighieri (1265–1321), angielskiego filozofa Francisa Bacona (1561–1626) i rosyjskiego pisarza Lwa Tołstoja (1828–1910). Tukidydes w swojej Wojnie peloponeskiej napisał: „jest zwyczajem człowieka pokładać beztroską wiarę w to, czego pragnie i odpychać do siebie myśli o tym, co mu się nie podoba”[48]. W Boskiej komedii Tomasz z Akwinu ostrzega Dantego w czasie spotkania w Raju: „opinia-przedwczesna-często może skłonić człowieka w niewłaściwą stronę, a potem przywiązanie do własnej opinii wiąże i ogranicza umysł”[49]. Bacon w Novum Organum napisał

Ludzki rozum, gdy już uzyska opinię, czy otrzymując ją od kogoś czy samemu do niej dochodząc, naciąga wszystko inne aby ją podpierało i zgadzało się z nią. I nawet jeśli będą liczniejsze i ważniejsze przykłady na korzyść drugiej strony, będą one pomijane i pogardzane, albo na jakiejś podstawie odrzucane[50].

Bacon zauważył, że nieprawidłowa ocena dowodów napędza „wszystkie przesądy, czy to w astrologię, sny, omeny, wyroki boskie czy podobne”[50]. Lew Tołstoj w swoim eseju Czym jest sztuka? napisał:

Wiem, że większość ludzi – nie tylko ci uznawani za mądrych, ale nawet ci, którzy są naprawdę pojętni i zdolni do zrozumienia najtrudniejszych naukowych, matematycznych czy filozoficznych problemów – rzadko potrafi dostrzec nawet najprostszą i najbardziej oczywistą prawdę, jeśli zmusiłoby ich to do przyznania się do błędu w konkluzjach do jakich sami doszli, czasem z wielkim trudem – konkluzjach z których są dumni, które wpoili innym i zgodnie z którymi żyli[51].

W eseju Królestwo Boga jest w tobie napisał podobnie: „Najtrudniejsze tematy mogą być wytłumaczone najgłupszemu człowiekowi, o ile nie uformował sobie wcześniej na ich temat żadnej opinii. Ale najprostsze rzeczy nie mogą być wyjaśnione najinteligentniejszemu człowiekowi, jeśli jest mocno przeświadczony, że już wie, bez cienia wątpliwości, o co w nich chodzi”[52].

Eksperymenty Wasona

Termin „efekt potwierdzenia” wprowadził angielski psycholog Peter Wason[53]. W swoich eksperymentach w latach 1960. dawał badanym zadanie odgadnięcia prostej reguły, według której akceptowane są trójki liczb. Na początku mówił badanym, że trójka (2, 4, 6) spełnia tę regułę. Badani mogli tworzyć własne trójki liczb, a eksperymentator mówił im, czy spełniają regułę, czy nie[54][55].

Choć reguła brzmiała „dowolna sekwencja rosnąca”, badani mieli wielkie trudności z jej odgadnięciem, często zakładając bardziej skomplikowane reguły, takie jak „środkowa liczba jest średnią pierwszej i trzeciej”[54]. Badani przeprowadzali testy jedynie, aby potwierdzić swoje przypuszczenia, podając trójki, które spełniały wymyślone przez nich reguły. Przykładowo, zgadując że reguła brzmi „każda liczba jest o dwa większa od poprzedniej” testowali trójki, które ją spełniają, takie jak (11, 13, 15), zamiast takich, które jej nie spełniają, jak np. (11, 12, 19)[56].

Wason akceptował krytyczny racjonalizm, zgodnie z którym naukowa hipoteza musi być przetestowana przez próbę falsyfikacji. Badania pokazały, że ludzie próbują raczej potwierdzać, zamiast zaprzeczać i dlatego nazwał to „efektem potwierdzenia”[57]. Wason użył też tego pojęcia do wyjaśnienia wyników testu selekcji[58]. Test ten polega na zaprezentowaniu badanym częściowej informacji na temat zbioru obiektów i poproszenia ich o wskazanie, jakich jeszcze informacji potrzebują, aby rozstrzygnąć, czy dana implikacja („Jeśli A to B”) jest prawdziwa. Zostało wielokrotnie pokazane, że ludzie bardzo słabo rozwiązują takie testy, w większości wypadków ignorując informacje, które potencjalnie mogłyby wykazać nieprawdziwość tej implikacji[59][60].

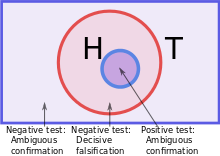

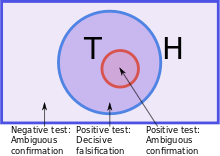

Krytyka Klaymana i Ha

W 1987 Joshua Klayman i Young-Won Ha opublikowali pracę podważającą pierwotne wnioski Wasona i pokazującą, że jego eksperymenty nie tyle pokazywały tendencję do potwierdzania, ile tendencję do przeprowadzania testów zgodnych z założoną opinią[61]. Nazwali to „strategią pozytywnego testu”[7]. Jest ona przykładem heurystyki: uproszczonego rozumowania, które nie zawsze daje dobre rezultaty, ale jest łatwe do przeprowadzenia[1]. Klayman i Ha analizowali rozumowanie badanych z punktu widzenia prawdopodobieństwa subiektywnego i teorii informacji. Z tego punktu widzenia każda odpowiedź na zadane pytanie daje pewną ilość informacji, zależną od wcześniejszych założeń. Najlepszy test każdej hipotezy to taki test, który daje największą ilość informacji. Klayman i Ha stwierdzili, że gdy ludzie rozwiązują realne problemy, zwykle oczekują bardzo specyficznych rozwiązań o niewielkim obiektywnym prawdopodobieństwie. W takim przypadku test próbujący potwierdzić jakąś hipotezę daje więcej informacji, niż próbujący ją obalić[12]. W przypadku testu przeprowadzonego przez Wasona prawdziwa hipoteza – dowolna sekwencja rosnąca – była bardzo ogólna, dlatego testy próbujące potwierdzić różne hipotezy dawały bardzo niewiele informacji. Klayman i Ha poparli swoją analizę wynikami innej wersji tego samego eksperymentu, w którym zamiast informacji „zgodna z regułą” i „niezgodna z regułą” trójki liczb otrzymywały oznaczenia „DAX” i „MED”. Pozwoliło to uniknąć sugerowania, że celem jest znalezienie jakiejś specyficznej reguły. W tej wersji badani uzyskiwali znacznie lepsze wyniki[62][63].

Te oraz inne publikacje sprawiły, że w późniejszych latach psychologowie odeszli od badania efektu potwierdzenia jako przeciwwagi falsyfikacji, zamiast tego skupiając się na badaniu, czy ludzie testują swoje hipotezy w taki sposób, aby uzyskać jak najwięcej informacji. Poszukiwania „prawdziwego” efektu potwierdzenia doprowadziły do odkrycia wielu efektów związanych z przetwarzaniem informacji przez ludzi[64].

Wyjaśnienia

Efekt potwierdzenia jest zwykle tłumaczony jako wynik automatycznego przetwarzania informacji. Ludzie nie oszukują siebie świadomie, ale używają podświadomych schematów przetwarzania informacji[13][65]. Amerykański psycholog Robert Maccoun napisał, że większość błędów w przetwarzaniu informacji pojawia się jako niezamierzony efekt łączenia mechanizmów „gorących” (emocjonalnych) i „zimnych” (racjonalnych)[66].

Kognitywiści wyjaśniają efekt potwierdzenia jako skutek ograniczeń ludzkich możliwości w przetwarzaniu skomplikowanych informacji i używania „skrótów”, czyli heurystyk[67]. Przykładowo ludzie mogą oceniać wiarygodność jakiejś informacji na podstawie heurystyki dostępności, czyli tego, jak łatwo tę informację sobie przypomnieć[68]. Może on też być związany z faktem, że ludzie skupiają się zwykle na jednej tylko rzeczy, co sprawia, że trudno im testować kilka konkurencyjnych hipotez jednocześnie[69]. Wreszcie „strategia pozytywnego testu” zaproponowana przez Klaymana i Ha jest heurystyką polegającą na stopniowym zawężaniu swoich hipotez, starając się przy każdym teście uzyskać jak najwięcej informacji. Ta strategia umożliwia uniknięcie trudnego bądź nawet niemożliwego zadania opracowania najlepszego pytania w danej sytuacji. Nie jest jednak uniwersalna i sprawia, że ludzie nie zauważają faktów, które mogłyby podważyć ich aktualne przeświadczenia[12][70].

Wyjaśnienia oparte na motywacji uwzględniają efekt wiary i pożądania czegoś, nazywany czasem „myśleniem życzeniowym”[71][72]. Zostało pokazane, że ludzie preferują myślenie o przyjemnych rzeczach (jest to nazywane „efektem Pollyanny”)[73]. W odniesieniu do argumentów i dowodów może to tłumaczyć, czemu te, które prowadzą do przyjemnych konkluzji, są faworyzowane[71]. W eksperymentach, w których manipulowano zaletami różnych konkluzji, badani wymagali silnych dowodów na konkluzje nieprzyjemne, a wystarczały im słabe dla konkluzji przyjemnych. Różnicę można zobrazować tym, że jedne konkluzje budziły pytanie: Czy mogę w to wierzyć?, a inne Czy muszę w to wierzyć[74]?[75]. Choć niesprzeczność poglądów jest zaletą, zbytnie dążenie do niej może uniemożliwić neutralną ocenę nowych, zaskakujących informacji[71]. Psycholog Ziva Kunda opublikowała teorię łączącą wyjaśnienia motywacyjne i kognitywistyczne, twierdząc, że motywacje powodują pojawienie się tego efektu, ale czynniki kognitywistyczne odpowiadają za jego siłę[76].

Alternatywne wyjaśnienia tego efektu opierają się o analizę kosztów i korzyści. Zakładają one, że ludzie nie testują informacji w sposób bezstronny, ale że szacują koszty możliwych pomyłek[77]. Korzystając z pojęć psychologii ewolucyjnej, James Friedrich zasugerował, że głównym celem ludzi przy testowaniu hipotez nie jest osiągnięcie prawdy, ale uniknięcie najkosztowniejszych błędów. Przykładowo pracodawcy mogą testować kandydatów do pracy w sposób jednostronny, ponieważ głównie zależy im na odrzuceniu niepasujących kandydatów[78]. Yaacov Trope i Akiva Liberman rozwinęli dalej tę hipotezę, zakładając, że ludzie porównują dwa typy błędów: zaakceptowanie nieprawdziwej hipotezy i odrzucenie prawdziwej hipotezy. Przykładowo ktoś, kto nie doceni szczerości przyjaciela, może traktować go z podejrzliwością i zagrozić w ten sposób przyjaźni. Przecenienie szczerości przyjaciela może być mniej kosztowne. W takiej sytuacji racjonalne jest poszukiwanie, ocenianie i pamiętanie dowodów jego szczerości w nieobiektywny sposób[79]. Jeśli ktoś wydaje się być introwertykiem lub ekstrawertykiem, pytania dostosowane do tego wrażenia mogą być przejawem większej empatii[80]. Przykładowo rozmawiając z kimś, kto sprawia wrażenie introwertyka, zadanie pytania: Czy krępują cię rozmowy z obcymi? jest przejawem większym umiejętności społecznych, niż zadanie pytania: Czy lubisz głośne imprezy?. To powiązanie między efektem potwierdzenia i umiejętnościami społecznymi zostało potwierdzone w badaniach nad tym, jak studenci nawiązują nowe znajomości. Bardziej jednostronne pytania zadawali głównie studenci lepiej orientujący się w normach społecznych i tylko w rozmowach z osobami o wyższej pozycji[80].

Konsekwencje

W finansach

Efekt potwierdzenia może sprawiać, że inwestorzy przeceniają zalety jakiejś inwestycji, ignorując dowody, że może ona doprowadzić do straty[5][81]. W badaniach w użyciem politycznych rynków prognostycznych pokazano, że większe zyski osiągają ci inwestorzy, którzy unikają efektu potwierdzenia, na przykład inwestując w kandydatów na podstawie ich wyników w debatach, nie mając do nich żadnych osobistych preferencji[82]. Aby zwalczyć efekt potwierdzenia, inwestorzy mogą starać się przyjąć punkt widzenia strony przeciwnej „na potrzeby dyskusji”[83]. Jedną z takich technik jest próba wyobrażenia sobie, że ich inwestycja upadła, i zadanie pytania, czemu mogło to się stać[5].

W medycynie

Psycholog Raymond Nickerson przytacza efekt potwierdzenia jako przyczynę nieefektywności stosowanej przez stulecia tradycyjnej medycyny[84]. Jeśli pacjent wyzdrowiał, lekarze uznawali, że była to zasługa leczenia, nie biorąc pod uwagę alternatywnego wyjaśnienia, że choroba mogła sama ustąpić[84]. To samo zjawisko może wyjaśniać współczesną wiarę w skuteczność medycyny niekonwencjonalnej. Jej zwolennicy przytaczają różne dowody anegdotyczne jej skuteczności, podczas gdy badania naukowe tej skuteczności nie potwierdzają[85][86][87].

Terapia poznawcza opracowana w latach 60. XX wieku przez Aarona T. Becka opiera się na założeniu, że zaburzenia depresyjne są związane z zaburzeniami w interpretowaniu informacji[88][89]. Aby je leczyć, uczy ludzi traktować dowody bezstronnie, zamiast selektywnie wyszukiwać negatywne informacje podtrzymujące stan depresyjny[90]. Podobne podejścia są również stosowane w leczeniu fobii i hipochondrii[91].

W polityce i prawie

Raymond Nickerson sugeruje, że ludzie podejmujący decyzje prawne i polityczne mogą czasem podlegać efektom podświadomego efektu potwierdzenia, skłaniającego ich do dochodzenia do konkluzji, które wcześniej wygłaszali inni sędziowie, ławnicy albo politycy[92]. Ponieważ dowody przedstawione w czasie procesu mogą być bardzo skomplikowane, a ławnicy często podejmują decyzję bardzo szybko, sugeruje to, że może występować u nich efekt polaryzacji poglądów. To podejście przewiduje, że ławnicy będą stawali się bardziej radykalni w swoich poglądach po zaprezentowaniu im większej liczby dowodów. Zostało to potwierdzone w eksperymentach z inscenizowanymi procesami[93][94]. Badania pokazują, że efekt potwierdzenia ma miejsce zarówno w procesach typu inkwizycyjnego, jak i kontradyktoryjnego[95].

Efekt potwierdzenia może być czynnikiem powodującym powstawanie i eskalację konfliktów, od gorących debat politycznych aż do wojen. Interpretując dowody na korzyść swojej opinii, każda ze stron z upływem czasu staje się coraz pewniejsza swojej racji[96]. Dodatkowo efekt potwierdzenia może sprawiać, że ludzie ignorują bądź nieprawidłowo interpretują oznaki nadchodzącego konfliktu. Przykładowo psychologowie Stuart Sutherland i Thomas Kida niezależnie pokazali, że amerykański admirał Husband Edward Kimmel wykazywał oznaki efektu potwierdzenia po pierwszych oznakach japońskiego ataku na Pearl Harbor[59][97].

Inny przykład efektu potwierdzenia pokazał Philip E. Tetlock w swoich dwudziestoletnich badaniach nad skutecznością przewidywań ekspertów politycznych. Badania objęły 284 ekspertów i około 28 tys. przewidywań. Wynikło z nich, że przewidywania ekspertów nie różniły się istotnie od czysto losowych. W szczególności przewidywania bardziej dogmatycznych ekspertów były wyraźnie gorsze. Tetlock jako przyczynę podał efekt potwierdzenia, który uniemożliwiał takim ekspertom branie pod uwagę nowych informacji, jeśli przeczyłyby one ich już wygłoszonym opiniom[98].

W zjawiskach paranormalnych

Efekt potwierdzenia może również stanowić przyczynę utrzymującej się wiary we wróżby. Przez wygłaszanie wielu ogólnikowych stwierdzeń osoba wróżąca daje szansę słuchaczom wybrać spośród nich te, które najlepiej odnoszą się do ich własnego życia[99]. Jest to jedna z technik zimnego odczytu, który pozwala stworzyć wrażenie, że wie się o kliencie bardzo dużo, nie mając żadnych o nim informacji[99]. James Randi porównał zapis rozmowy klienta z jasnowidzem z relacją klienta z tej rozmowy i pokazał, że klient o wiele lepiej pamiętał informacje „trafione” od „nietrafionych”[100].

Jako uderzający przykład efektu potwierdzenia w rzeczywistym świecie Nickerson podaje piramidologię: doszukiwanie się znaczenia w proporcjach egipskich piramid[101]. Każda piramida ma wiele różnych parametrów, które można porównywać na wiele różnych sposobów. Dlatego jest niemalże pewne, że przy wystarczająco dokładnym szukaniu znajdzie się wśród nich proporcje odpowiadające dowolnej założonej wartości, przykładowo średnicy Ziemi[101].

W nauce

Metoda naukowa obejmuje wiele procedur, których celem jest niwelowanie efektów błędów poznawczych, takich jak efekt potwierdzenia[102]. W historii nauki wielokrotnie zdarzało się jednak, że naukowcy odrzucali nowe odkrycia z powodu selektywnego interpretowania informacji i ignorowania niewygodnych danych[102]. Przeprowadzone badania pokazały, że efekt potwierdzenia może bardzo wyraźnie wpływać na osiągnięcia naukowe. Wielokrotnie pokazano, że naukowcy znacznie lepiej oceniają badania, których wyniki potwierdzają ich własne opinie, niż badania, których wyniki są z nimi sprzeczne[103][104][65]. Jest to niezgodne z założeniami nauki, które uznają że wyniki każdego badania powinny być oceniane jedynie na podstawie tego, jak zostało ono przeprowadzone i opisane, a nie na podstawie tego, jakie są jego wyniki[104]. Efekt potwierdzenia może w ten sposób blokować postęp naukowy, sprawiając, że przełomowe wyniki są traktowane jako skutek błędów w badaniach i ignorowane przez naukowców[103][105]. W kontekście prowadzenia badań naukowych efekt potwierdzenia może powodować utrzymywanie się jakichś teorii i dalsze prowadzenie nad nimi badań nawet wtedy, gdy istnieją dowody obalające je[59][106]. Przykładem mogą być prowadzone przez dziesięciolecia badania nad parapsychologią mimo braków jakichkolwiek sukcesów[107]. Efekt potwierdzenia w szczególności może sprawiać, że publikowane wyniki nie obejmują całego zakresu badań nad jakimś zagadnieniem. Wyniki, które kłócą się z oczekiwaniami eksperymentatora, mogą zostać odrzucone jako „niepowodzenia” i nigdy nie opublikowane. Jest to nazywane „efektem szuflady”. Aby go zwalczyć, niektóre uniwersytety prowadzą specjalne szkolenia z unikania błędów poznawczych[108]. Współcześnie, aby uznać eksperyment za dobrze przeprowadzony, wymaga się, żeby był przeprowadzony na losowej próbce danych, a jeśli uczestniczą w nich ludzie, żeby stosować podwójnie ślepą próbę[108][109]. Wymaga się również, żeby cały proces został zrecenzowany, choć według badań sam proces recenzowania też może ulegać temu samemu błędowi[104].

W samoocenie

Psychologia społeczna wskazuje na dwie tendencje, które wpływają na to, jak ludzie przetwarzają informacje o sobie samych. Pierwszą jest autoweryfikacja, polegająca na szukaniu potwierdzenia własnej opinii o sobie, a drugą autowaloryzacja polegająca na szukaniu pozytywnych opinii o sobie. Obie te tendencje są wzmacniane przez błędy poznawcze[110]. W eksperymentach pokazano, że gdy ludzie otrzymują oceny sprzeczne z własną opinią o sobie samych, rzadziej zwracają na nie uwagę i gorzej je zapamiętują, niż gdy otrzymują oceny zgodne z tą opinią[111][112][113]. Zmniejszają znaczenie takich ocen przez interpretowanie ich jako mało wiarygodnych[111][114][115]. Podobne eksperymenty pokazały, że ludzie lepiej zapamiętują oceny pozytywne niż negatywne[110].

Zobacz też

Przypisy

- ↑ a b Plous 1993 ↓, s. 233.

- ↑ John M. Darley, Paget H. Gross, Stereotypes and prejudice: essential readings, Psychology Press, 2000, OCLC 42823720.s.

- ↑ Risen i Gilovich 2007 ↓, s. 110–130.

- ↑ Risen i Gilovich 2007 ↓, s. 113.

- ↑ a b c Jason Zweig, How to Ignore the Yes-Man in Your Head, Dow Jones & Company, 19 listopada 2009 [dostęp 2010-06-13].

- ↑ Nickerson 1998 ↓, s. 177–178.

- ↑ a b c d Kunda 1999 ↓, s. 112–115.

- ↑ a b Baron 2000 ↓, s. 162–164.

- ↑ Kida 2006 ↓, s. 162–165.

- ↑ Patricia G. Devine, Edward R. Hirt, Elizabeth M. Gehrke. Diagnostic and confirmation strategies in trait hypothesis testing. „Journal of Personality and Social Psychology”. 58 (6), s. 952–963, 1990. American Psychological Association. DOI: 10.1037/0022-3514.58.6.952. ISSN 1939-1315.

- ↑ Yaacov Trope, Miriam Bassok. Confirmatory and diagnosing strategies in social information gathering. „Journal of Personality and Social Psychology”. 43 (1), s. 22–34, 1982. American Psychological Association. DOI: 10.1037/0022-3514.43.1.22. ISSN 1939-1315.

- ↑ a b c Joshua Klayman, Young-Won Ha. Confirmation, Disconfirmation and Information in Hypothesis Testing. „Psychological Review”. 94 (2), s. 211–228, 1987. American Psychological Association. DOI: 10.1037/0033-295X.94.2.211. ISSN 0033-295X. [dostęp 2009-08-14].

- ↑ a b c Oswald i Grosjean 2004 ↓.

- ↑ Oswald i Grosjean 2004 ↓, s. 82–83.

- ↑ Ziva Kunda, G.T. Fong, R. Sanitoso, E. Reber. Directional questions direct self-conceptions. „Journal of Experimental Social Psychology”. 29, s. 62–63, 1993. Society of Experimental Social Psychology. ISSN 0022-1031.

- ↑ a b E. Shafir. Choosing versus rejecting: why some options are both better and worse than others. „Memory and Cognition”. 21 (4), s. 546–556, 1983. PMID: 8350746.

- ↑ Mark Snyder, William B. Swann, Jr. Hypothesis-Testing Processes in Social Interaction. „Journal of Personality and Social Psychology”. 36 (11), s. 1202–1212, 1978. American Psychological Association. DOI: 10.1037/0022-3514.36.11.1202.

- ↑ a b Kunda 1999 ↓, s. 117–118.

- ↑ a b Clifford R. Mynatt, Michael E. Doherty, Ryan D. Tweney. Consequences of confirmation and disconfirmation in a simulated research environment. „Quarterly Journal of Experimental Psychology”. 30 (3), s. 395–406, 1978. DOI: 10.1080/00335557843000007.

- ↑ Kida 2006 ↓, s. 157.

- ↑ a b c d e Charles G. Lord, Lee Ross, Mark R. Lepper. Biased assimilation and attitude polarization: The effects of prior theories on subsequently considered evidence. „Journal of Personality and Social Psychology”. 37 (11), s. 2098–2109, 1979. American Psychological Association. DOI: 10.1037/0022-3514.37.11.2098. ISSN 0022-3514.

- ↑ a b Baron 2000 ↓, s. 201–202.

- ↑ Vyse 1997 ↓, s. 122.

- ↑ a b c Charles S. Taber, Milton Lodge. Motivated Skepticism in the Evaluation of Political Beliefs. „American Journal of Political Science”. 50 (3), s. 755–769, July 2006. Midwest Political Science Association. DOI: 10.1111/j.1540-5907.2006.00214.x. ISSN 0092-5853.

- ↑ a b Drew Westen, Pavel S. Blagov, Keith Harenski, Clint Kilts i inni. Neural Bases of Motivated Reasoning: An fMRI Study of Emotional Constraints on Partisan Political Judgment in the 2004 U.S. Presidential Election. „Journal of Cognitive Neuroscience”. 18 (11), s. 1947–1958, 2006. Massachusetts Institute of Technology. DOI: 10.1162/jocn.2006.18.11.1947. PMID: 17069484. [dostęp 2009-08-14].

- ↑ V. Gadenne, M. Oswald. Entstehung und Veränderung von Bestätigungstendenzen beim Testen von Hypothesen [Formation and alteration of confirmatory tendencies during the testing of hypotheses]. „Zeitschrift für experimentelle und angewandte Psychologie”. 33, s. 360–374, 1986.

- ↑ Reid Hastie, Bernadette Park, Social cognition: key readings, New York: Psychology Press, 2005, OCLC 55078722.

- ↑ a b c Oswald i Grosjean 2004 ↓, s. 88–89.

- ↑ Charles Stangor, David McMillan. Memory for expectancy-congruent and expectancy-incongruent information: A review of the social and social developmental literatures. „Psychological Bulletin”. 111 (1), s. 42–61, 1992. American Psychological Association. DOI: 10.1037/0033-2909.111.1.42.

- ↑ a b M. Snyder, N. Cantor. Testing hypotheses about other people: the use of historical knowledge. „Journal of Experimental Social Psychology”. 15, s. 330–342, 1979. DOI: 10.1016/0022-1031(79)90042-8.

- ↑ Kunda 1999 ↓, s. 225–232.

- ↑ Rasyid Sanitioso, Ziva Kunda, G.T. Fong. Motivated recruitment of autobiographical memories. „Journal of Personality and Social Psychology”. 59 (2), s. 229–241, 1990. American Psychological Association. DOI: 10.1037/0022-3514.59.2.229. ISSN 0022-3514. PMID: 2213492.

- ↑ a b Dan Russell, Warren H. Jones. When superstition fails: Reactions to disconfirmation of paranormal beliefs. „Personality and Social Psychology Bulletin”. 6 (1), s. 83–88, 1980. Society for Personality and Social Psychology. DOI: 10.1177/014616728061012. ISSN 1552-7433.

- ↑ Deanna Kuhn, Joseph Lao. Effects of Evidence on Attitudes: Is Polarization the Norm?. „Psychological Science”. 7 (2), s. 115–120, March 1996. American Psychological Society. DOI: 10.1111/j.1467-9280.1996.tb00340.x.

- ↑ Baron 2000 ↓, s. 201.

- ↑ a b c Lee Ross, Craig A. Anderson, Judgment under uncertainty: Heuristics and biases, Cambridge University Press, 1982, s. 129–152, OCLC 7578020.

- ↑ a b c Nickerson 1998 ↓, s. 187.

- ↑ Kunda 1999 ↓, s. 99.

- ↑ Lee Ross, Mark R. Lepper, Michael Hubbard. Perseverance in self-perception and social perception: Biased attributional processes in the debriefing paradigm. „Journal of Personality and Social Psychology”. 32 (5), s. 880–892, 1975. American Psychological Association. DOI: 10.1037/0022-3514.32.5.880. ISSN 0022-3514. PMID: 1185517.

- ↑ a b Baron 2000 ↓, s. 197–200.

- ↑ a b c Fine 2006 ↓, s. 66–70.

- ↑ a b Plous 1993 ↓, s. 164–166.

- ↑ D.A. Redelmeir, Amos Tversky. On the belief that arthritis pain is related to the weather. „Proceedings of the National Academy of Science”. 93, s. 2895–2896, 1996. DOI: 10.1073/pnas.93.7.2895.

- ↑ a b c Kunda 1999 ↓, s. 127–130.

- ↑ Plous 1993 ↓, s. 162–164.

- ↑ Klaus Fielder, Cognitive Illusions: A Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove, UK: Psychology Press, 2004, OCLC 55124398.

- ↑ Thucydides, The History of the Peloponnesian War, The Internet Classics Archive [dostęp 2010-05-27].

- ↑ Alighieri, Dante. Paradiso canto XIII: 118–120. Trans. Allen Mandelbaum.

- ↑ a b Bacon, Francis (1620). Novum Organum.

- ↑ Lew Tołstoj, Что такое искусство? p. 124 (1899).

- ↑ Lew Tołstoj, Królestwo Boga jest w tobie, rozdział 3.

- ↑ Maggie Gale, Linden J. Ball. Does Positivity Bias Explain Patterns of Performance on Wason’s 2-4-6 task?. „Proceedings of the Twenty-Fourth Annual Conference of the Cognitive Science Society”, 2002. Routledge. OCLC 469971634.

- ↑ a b Peter C. Wason. On the failure to eliminate hypotheses in a conceptual task. „Quarterly Journal of Experimental Psychology”. 12 (3), s. 129–140, 1960. Psychology Press. DOI: 10.1080/17470216008416717. ISSN 1747-0226.

- ↑ Nickerson 1998 ↓, s. 179.

- ↑ Lewicka 1998 ↓, s. 238.

- ↑ Oswald i Grosjean 2004 ↓, s. 79–96.

- ↑ Peter C. Wason. Reasoning about a rule. „Quarterly Journal of Experimental Psychology”. 20 (3), s. 273–228, 1968. Psychology Press. DOI: 10.1080/14640746808400161. ISSN 1747-0226.

- ↑ a b c Stuart Sutherland, Irrationality, London: Pinter and Martin, 2007, s. 95–103, OCLC 72151566.

- ↑ Jerome H. Barkow, Leda Cosmides, John Tooby, The adapted mind: evolutionary psychology and the generation of culture, Oxford University Press US, 1995, s. 181–184, OCLC 33832963.

- ↑ Oswald i Grosjean 2004 ↓, s. 81–82, 86–87.

- ↑ Lewicka 1998 ↓, s. 239.

- ↑ Ryan D. Tweney, Michael E. Doherty, Winifred J. Worner, Daniel B. Pliske i inni. Strategies of rule discovery in an inference task. „The Quarterly Journal of Experimental Psychology”. 32 (1), s. 109–123, 1980. Psychology Press. DOI: 10.1080/00335558008248237. ISSN 1747-0226.

- ↑ Oswald i Grosjean 2004 ↓, s. 86–89.

- ↑ a b Hergovich, Schott i Burger 2010 ↓.

- ↑ Maccoun 1998 ↓.

- ↑ Friedrich 1993 ↓, s. 298.

- ↑ Kunda 1999 ↓, s. 94.

- ↑ Nickerson 1998 ↓, s. 198–199.

- ↑ Nickerson 1998 ↓, s. 200.

- ↑ a b c Nickerson 1998 ↓, s. 197.

- ↑ Baron 2000 ↓, s. 206.

- ↑ Margaret W. Matlin, Cognitive Illusions: A Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove: Psychology Press, 2004, s. 255–272, OCLC 55124398.

- ↑ Erica Dawson, Thomas Gilovich, Dennis T. Regan. Motivated Reasoning and Performance on the Wason Selection Task. „Personality and Social Psychology Bulletin”. 28 (10), s. 1379–1387, October 2002. Society for Personality and Social Psychology. DOI: 10.1177/014616702236869. [dostęp 2009-09-30].

- ↑ Peter H. Ditto, David F. Lopez. Motivated skepticism: use of differential decision criteria for preferred and nonpreferred conclusions. „Journal of personality and social psychology”. 63 (4), s. 568–584, 1992. American Psychological Association. DOI: 10.1037/0022-3514.63.4.568. ISSN 0022-3514.

- ↑ Nickerson 1998 ↓, s. 198.

- ↑ Oswald i Grosjean 2004 ↓, s. 91–93.

- ↑ Friedrich 1993 ↓, s. 299, 316–317.

- ↑ Y. Trope, A. Liberman, Social Psychology: Handbook of basic principles, New York: Guilford Press, 1996, OCLC 34731629.

- ↑ a b Benoit Dardenne, Jacques-Philippe Leyens. Confirmation Bias as a Social Skill. „Personality and Social Psychology Bulletin”. 21 (11), s. 1229–1239, 1995. Society for Personality and Social Psychology. DOI: 10.1177/01461672952111011. ISSN 1552-7433.

- ↑ Michael M. Pompian, Behavioral finance and wealth management: how to build optimal portfolios that account for investor biases, John Wiley and Sons, 2006, s. 187–190, OCLC 61864118.

- ↑ Denis J. Hilton. The psychology of financial decision-making: Applications to trading, dealing, and investment analysis. „Journal of Behavioral Finance”. 2 (1), s. 37–39, 2001. Institute of Behavioral Finance. DOI: 10.1207/S15327760JPFM0201_4. ISSN 1542-7579.

- ↑ David Krueger, John David Mann, The Secret Language of Money: How to Make Smarter Financial Decisions and Live a Richer Life, McGraw Hill Professional, 2009, s. 112–113, OCLC 277205993.

- ↑ a b Nickerson 1998 ↓, s. 192.

- ↑ Goldacre 2008 ↓, s. 233.

- ↑ Simon Singh, Edzard Ernst, Trick or Treatment?: Alternative Medicine on Trial, London: Bantam, 2008, s. 287–288.

- ↑ Kimball Atwood. Naturopathy, Pseudoscience, and Medicine: Myths and Fallacies vs Truth. „Medscape General Medicine”. 6 (1), 2004.

- ↑ Michael Neenan, Windy Dryden, Cognitive therapy: 100 key points and techniques, Psychology Press, 2004, OCLC 474568621.

- ↑ Ivy-Marie Blackburn, Kate M. Davidson, Cognitive therapy for depression & anxiety: a practitioner’s guide, Wiley-Blackwell, 1995, OCLC 32699443.

- ↑ Baron 2000 ↓, s. 195.

- ↑ Allison G. Harvey, Edward Watkins, Warren Mansell, Cognitive behavioural processes across psychological disorders: a transdiagnostic approach to research and treatment, Oxford University Press, 2004, s. 172–173,176, OCLC 602015097.

- ↑ Nickerson 1998 ↓, s. 191–193.

- ↑ D.G. Myers, H. Lamm. The group polarization phenomenon. „Psychological Bulletin”. 83, s. 602–627, 1976. DOI: 10.1037/0033-2909.83.4.602.

- ↑ Diane F. Halpern, Critical thinking across the curriculum: a brief edition of thought and knowledge, Lawrence Erlbaum Associates, 1987, OCLC 37180929.

- ↑ Kent Roach. Wrongful Convictions: Adversarial and Inquisitorial Themes”. „North Carolina Journal of International Law and Commercial Regulation”. 35, 2010.

- ↑ Baron 2000 ↓, s. 191,195.

- ↑ Kida 2006 ↓, s. 155.

- ↑ Philip E. Tetlock, Expert Political Judgment: How Good Is It? How Can We Know?, Princeton, N.J.: Princeton University Press, 2005, s. 125–128, OCLC 56825108.

- ↑ a b Jonathan C. Smith, Pseudoscience and Extraordinary Claims of the Paranormal: A Critical Thinker’s Toolkit, John Wiley and Sons, 2009, s. 149–151, OCLC 319499491.

- ↑ James Randi, James Randi: psychic investigator, Boxtree, 1991, s. 58–62, OCLC 26359284.

- ↑ a b Nickerson 1998 ↓, s. 190.

- ↑ a b Nickerson 1998 ↓, s. 192–194.

- ↑ a b Koehler 1993 ↓.

- ↑ a b c Mahoney 1977 ↓.

- ↑ Horrobin 1990 ↓.

- ↑ Robert W. Proctor, E. John Capaldi, Why science matters: understanding the methods of psychological research, Wiley-Blackwell, 2006, OCLC 318365881.

- ↑ Robert J. Sternberg, Critical Thinking in Psychology, Cambridge University Press, 2007, OCLC 69423179.

- ↑ a b William R. Shadish, Critical Thinking in Psychology, Cambridge University Press, 2007.

- ↑ Michael Shermer. The Political Brain. „Scientific American”, July 2006. ISSN 0036-8733. [dostęp 2009-08-14]. [zarchiwizowane z adresu].

- ↑ a b William B. Swann, Brett W. Pelham, Douglas S. Krull. Agreeable Fancy or Disagreeable Truth? Reconciling Self-Enhancement and Self-Verification. „Journal of Personality and Social Psychology”. 57 (5), s. 782–791, 1989. American Psychological Association. ISSN 0022-3514. PMID: 2810025.

- ↑ a b William B. Swann, Stephen J. Read. Self-Verification Processes: How We Sustain Our Self-Conceptions. „Journal of Experimental Social Psychology”. 17 (4), s. 351–372, 1981. Academic Press. DOI: 10.1016/0022-1031(81)90043-3. ISSN 0022-1031.

- ↑ Amber L. Story. Self-Esteem and Memory for Favorable and Unfavorable Personality Feedback. „Personality and Social Psychology Bulletin”. 24 (1), s. 51–64, 1998. Society for Personality and Social Psychology. DOI: 10.1177/0146167298241004. ISSN 1552-7433.

- ↑ Michael J. White, Daniel R. Brockett, Belinda G. Overstreet. Confirmatory Bias in Evaluating Personality Test Information: Am I Really That Kind of Person?. „Journal of Counseling Psychology”. 40 (1), s. 120–126, 1993. American Psychological Association. DOI: 10.1037/0022-0167.40.1.120. ISSN 0022-0167.

- ↑ William B. Swann, Stephen J. Read. Acquiring Self-Knowledge: The Search for Feedback That Fits. „Journal of Personality and Social Psychology”. 41 (6), s. 1119–1128, 1981. American Psychological Association. ISSN 0022-3514.

- ↑ J. Sidney Shrauger, Adrian K. Lund. Self-evaluation and reactions to evaluations from others. „Journal of Personality”. 43 (1), s. 94–108, 1975. Duke University Press. DOI: 10.1111/j.1467-6494.1975.tb00574. PMID: 1142062.

Bibliografia

- Jonathan Baron, Thinking and Deciding, New York: Cambridge University Press, 2000, OCLC 316403966.

- Cordelia Fine, A Mind of its Own: how your brain distorts and deceives, Cambridge, UK: Icon books, 2006, OCLC 60668289.

- James Friedrich. Primary error detection and minimization (PEDMIN) strategies in social cognition: a reinterpretation of confirmation bias phenomena. „Psychological Review”. 100 (2), s. 298–319, 1993. American Psychological Association. DOI: 10.1037/0033-295X.100.2.298. ISSN 0033-295X. PMID: 8483985.

- Ben Goldacre, Bad Science, London: Fourth Estate, 2008, OCLC 259713114.

- Andreas Hergovich, Reinhard Schott, Christoph Burger. Biased Evaluation of Abstracts Depending on Topic and Conclusion: Further Evidence of a Confirmation Bias Within Scientific Psychology. „Current Psychology”. 29, s. 188–209, 2010. DOI: 10.1007/s12144-010-9087-5.

- David F. Horrobin. The philosophical basis of peer review and the suppression of innovation. „Journal of the American Medical Association”. 263 (10), s. 1438–1441, 1990. DOI: 10.1001/jama.263.10.1438. PMID: 2304222.

- Thomas E. Kida, Don’t Believe Everything you Think: the 6 basic mistakes we make in thinking, Amherst, New York: Prometheus Books, 2006, OCLC 63297791.

- Jonathan J. Koehler. The influence of prior beliefs on scientific judgments of evidence quality. „Organizational Behavior and Human Decision Processes”. 56, s. 28–55, 1993. DOI: 10.1006/obhd.1993.1044.

- Ziva Kunda, Social Cognition: Making Sense of People, MIT Press, 1999, OCLC 40618974.

- Maria Lewicka, Personal Control in Action: cognitive and motivational mechanisms, Springer, 1998, s. 233–255, OCLC 39002877.

- Robert J. Maccoun. Biases in the interpretation and use of research results. „Annual Review of Psychology”. 49, s. 259–287, 1998. DOI: 10.1146/annurev.psych.49.1.259. PMID: 15012470.

- Michael J. Mahoney. Publication prejudices: an experimental study of confirmatory bias in the peer review system. „Cognitive Therapy and Research”. 1, s. 161–175, 1977. DOI: 10.1007/BF01173636.

- Raymond S. Nickerson. Confirmation Bias: a Ubiquitous Phenomenon in Many Guises. „Review of General Psychology”. 2 (2), s. 175–220, 1998. Educational Publishing Foundation. DOI: 10.1037/1089-2680.2.2.175. ISSN 1089-2680.

- Margit E. Oswald, Stefan Grosjean, Cognitive Illusions: a Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove, UK: Psychology Press, 2004, s. 79–96, OCLC 55124398.

- Scott Plous, The Psychology of Judgment and Decision Making, McGraw-Hill, 1993, OCLC 26931106.

- Fenna Poletiek, Hypothesis-testing Behaviour, Hove, UK: Psychology Press, 2001, OCLC 44683470.

- Jane Risen, Thomas Gilovich, Critical Thinking in Psychology, Cambridge University Press, 2007, OCLC 69423179.

- Stuart A. Vyse, Believing in Magic: the psychology of superstition, New York: Oxford University Press, 1997, OCLC 35025826.

- Keith Stanovich: What Intelligence Tests Miss: the Psychology of Rational Thought. New Haven (CT): Yale University Press, 2009. ISBN 978-0-300-12385-2.

- Drew Westen, The Political Brain: the role of emotion in deciding the fate of the nation, PublicAffairs, 2007, OCLC 86117725.

Media użyte na tej stronie

Uriah Heep from "David Copperfield", Ink and wash drawing

Autor: Eric Chan from Palo Alto, United States, Licencja: CC BY 2.0

An attorney impeaching a witness during a mock trial competition.

Autor: MartinPoulter, Licencja: CC BY 3.0

A set-theoretic illustration of hypothesis testing in the case where the working hypothesis (H) encompasses the true rule (T), with arrows to indicate the relevance of the figure to confirmation. Adapted from Figure 3 of Joshua Klayman, Young-Won Ha (1987). "Confirmation, Disconfirmation and Information in Hypothesis Testing". Psychological Review (American Psychological Association) 94 (2): 211–228. ISSN 0033-295X

Autor: Jan Ainali, Licencja: CC BY 3.0

Philips MRI in Sahlgrenska Universitetsjukhuset, Gothenburg, Sweden.

Autor: Joshuashearn, Licencja: CC BY-SA 3.0

Clockwise from top left: Glock G22, Glock G21, Kimber Custom Raptor, Dan Wesson Commander, Smith & Wesson .357, Ruger Blackhawk .357, Ruger SP101, Sig Sauer P220 Combat.

A set-theoretic illustration of hypothesis testing in the case where the true rule (T) encompasses the working hypothesis (H). Adapted from Figure 1 of Joshua Klayman, Young-Won Ha (1987). "Confirmation, Disconfirmation and Information in Hypothesis Testing". Psychological Review (American Psychological Association) 94 (2): 211–228. ISSN 0033-295X

A set-theoretic illustration of hypothesis testing in the case where the true rule (T) overlaps the working hypothesis (H). Adapted from Figure 2 of Joshua Klayman, Young-Won Ha (1987). "Confirmation, Disconfirmation and Information in Hypothesis Testing". Psychological Review (American Psychological Association) 94 (2): 211–228. ISSN 0033-295X