Superkomputer

Superkomputer – komputer znacznie przewyższający możliwościami powszechnie używane komputery, w szczególności dysponujący wielokrotnie większą mocą obliczeniową. Określenie pojawiło się w latach 60. XX w. w odniesieniu do komputerów produkowanych przez CDC i później przez przedsiębiorstwo Cray. Były one produkowane w dziesiątkach egzemplarzy i kosztowały po kilka milionów dolarów. Współcześnie większość superkomputerów to pojedyncze egzemplarze, zaprojektowane i wyprodukowane na zamówienie, zazwyczaj z seryjnie produkowanych procesorów i innych podzespołów. Koszty ich produkcji sięgają miliarda dolarów[1]. Od czerwca 2020 roku najszybszym superkomputerem na świecie jest Fugaku, wybudowany w Japonii.

Postęp techniczny w dziedzinie informatyki powoduje, że każdy superkomputer staje się przestarzały w ciągu kilku lat i jego używanie przestaje być opłacalne. Maszyny zaliczane dwadzieścia lat temu do klasy superkomputerów miały wydajność porównywalną z dzisiejszymi urządzeniami przenośnymi. Przykładowo iPhone XS w teście LINPACK uzyskuje wynik 7,5 GFLOPS, co w 1993 roku stawiałoby go na 30 miejscu wśród najszybszych superkomputerów świata[2][3].

Superkomputery używane są głównie do przeprowadzania złożonych fizycznych symulacji, takich jak prognozowanie pogody, badania zmian klimatu, modelowanie reakcji chemicznych, badanie aerodynamiki samolotów czy badania procesów starzenia broni termojądrowej.

Porównywanie wydajności superkomputerów

Główną miarą wydajności obliczeniowej, stosowaną obecnie dla superkomputerów, jest liczba wykonywanych w ciągu sekundy operacji na liczbach zmiennoprzecinkowych w precyzji 64-bitowej (FLOPS). Podaje się ją często z odpowiednim przedrostkiem SI. Przykładowo teraflops („TFLOPS”) to 1012 FLOPS, a petaflops („PFLOPS”) to 1015 FLOPS. Mierzy się ją za pomocą odpowiednich testów wzorcowych. Najpopularniejszym takim testem jest LINPACK, mierzący szybkość rozwiązywania gęstych układów równań liniowych za pomocą metody Gaussa. Ponieważ wiele problemów stawianych superkomputerom daje się sprowadzić do rozwiązywania takich równań, test ten jest wygodną abstrakcją pomiaru efektywności w rozwiązywaniu takich problemów. Superkomputery uzyskujące najwyższe wyniki w tym teście są od 1993 roku publikowane na liście TOP500, aktualizowanej dwa razy w roku.

Inną miarą jest sprawność energetyczna superkomputera wyrażana w jednostkach FLOPS/wat, uwzględniająca zużycie prądu przez superkomputer. Najefektywniejsze według tej miary superkomputery z listy TOP500 są publikowane od 2007 roku na liście Green500.

Historia

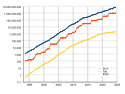

Suma mocy obliczeniowej 500 najszybszych superkomputerów

Najszybszy superkomputer na świecie

Superkomputer na 500 miejscu

Poniższa tabela przedstawia światowe rekordy szybkości dla komputerów ogólnego przeznaczenia i lata w których zostały ustanowione. Rekordy sprzed 1993 roku podane są na podstawie Computer History Museum[4], a od 1993 roku na podstawie listy TOP500[5].

Planowane superkomputery

W marcu 2020 roku podpisano umowę na budowę ponad dwueksaflopsowego komputera, klientem jest Departament Energii USA. Wykonawcą urządzenia El Capitan będą Cray wraz z Hewlett Packard Enterprise i Advanced Micro Devices przy współpracy z Lawrence Livermore National Laboratory[7][8]. El Capitan będzie służył do testowania broni termojądrowej i innych zbliżonych zadań.

Antycypowano, że przy obecnym postępie technicznym, pierwsze superkomputery o wydajności powyżej 1 eksaflopsa (1018, trylion FLOPS) powinny zostać zbudowane około 2019 roku[9][10]. Według Intel Corporation, obecny postęp techniczny w dziedzinie superkomputerów będzie zachowany przynajmniej do 2029 roku, kiedy powstaną komputery o szybkości zettaflopsów (1021, tryliard FLOPS)[11].

Rynek superkomputerów

W 2012 roku rynek superkomputerów miał wartość 11,1 mld $. Największymi producentami byli IBM (32% rynku), Hewlett-Packard (30,8%) i Dell (13,5%). Poniższa tabela przedstawia wartość rynku superkomputerów w ostatnich latach[12]:

| Segment rynku | 2011 | 2012 | Zmiana 2011/2012 |

|---|---|---|---|

| >500 000$ | 4,3 mld $ | 5,6 mld $ | +29,3% |

| 250 000$ – 499 000$ | 1,2 mld $ | 1,2 mld $ | -2,2% |

| 100 000$ – 249 000$ | 3,5 mld $ | 3,0 mld $ | -14,3% |

| <100 000$ | 1.2 mld $ | 1,2 mld $ | +1,2% |

| Suma | 10,3 mld $ | 11,1 mld $ | +7,7% |

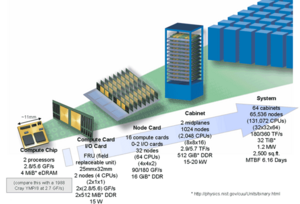

Budowa

Współczesne superkomputery uzyskują swoją wydajność dzięki połączeniu wielu tysięcy procesorów i zrównoleglaniu wykonywanych obliczeń. Z powodów ekonomicznych stosuje się procesory dostępne w produkcji masowej, ponieważ koszty zaprojektowania i wyprodukowania nowych typów procesorów są znacznie wyższe niż koszty produkcji superkomputerów[b][13][14]. Aby umożliwić efektywne wykorzystanie mocy obliczeniowej tych procesorów, używa się specjalnie zaprojektowanej pamięci hierarchicznej i najwydajniejszych dostępnych połączeń do przesyłania danych pomiędzy nimi. Z powodu takiej architektury, superkomputery mogą jednak osiągać wysoką wydajność jedynie dla obliczeń, które dają się w dużym stopniu zrównoleglić.

Zastosowanie

Superkomputery są używane w siłach zbrojnych, badaniach naukowych i w wielkich przedsiębiorstwach. Instytuty naukowe udostępniają czas swoich komputerów recenzowanym projektom naukowym, których lista jest często publicznie dostępna. Przykładowo na komputerach w ICM prowadzone są symulacje astrofizyczne, biochemiczne, hydrologiczne, epidemiologiczne i aerodynamiczne, jak również badania należące do teorii liczb i algebry liniowej[15].

Przykładowe zastosowania superkomputerów to:

- badanie struktury dużych biocząsteczek, takich jak lignina i celuloza, w celu zwiększania wydajności uzyskiwania z nich biopaliw[16],

- symulacje procesu spalania w silnikach spalinowych, w celu zwiększania ich wydajności[17],

- rozwój broni termojądrowej,

- symulacje aerodynamiki projektowanych samolotów[18] i samochodów ciężarowych[19],

- symulacje zachowania plazmy w tokamakach w badaniach nad kontrolowaną syntezą termojądrową[20],

- symulacje oddziaływań pomiędzy kwarkami a gluonami aby uzyskać dokładniejsze dane o parametrach cząstek elementarnych[21],

- badanie właściwości nanomateriałów w celu opracowania wydajniejszych superkondensatorów[22],

- symulacje zachowania elektronów wewnątrz nanostruktur w celu opracowania przyszłych układów elektronicznych[23].

Superkomputery w Polsce

Najszybsze superkomputery w Polsce, jednocześnie będące wśród 500 najszybszych superkomputerów na Świecie[5]:

- Athena w Cyfronet w Krakowie, o mocy obliczeniowej 7,71 PFLOPS - miejsce 105,

- Altair w PCSS w Poznaniu, o mocy obliczeniowej 5,88 PFLOPS - miejsce 145,

- Ares w Cyfronet w Krakowie, o mocy obliczeniowej 3,51 PFLOPS - miejsce 290,

- Tryton Plus na Politechnice Gdańskiej, o mocy obliczeniowej 2,82 PFLOPS - miejsce 462,

- Prometheus w Cyfronet w Krakowie, o mocy obliczeniowej 2,35 PFLOPS - miejsce 475.

Alternatywne rozwiązania

W zależności od typu problemu obliczeniowego, rozwiązanie go w sposób rozproszony może nakładać różne ograniczenia na architekturę i wydajność komunikacji pomiędzy poszczególnymi węzłami. W niektórych przypadkach superkomputery nie są najefektywniejszym rozwiązaniem i stosuje się rozwiązania alternatywne.

Projekty internetowe

Istnieje szereg problemów obliczeniowych, które można podzielić na wiele niezależnych, mniejszych zadań do wykonania. Takie problemy można rozwiązywać przy użyciu dużej ilości zwykłych komputerów, podłączonych do Internetu. Powstało kilka projektów działających na tej zasadzie. Uczestnicy takich projektów ściągają na swoje komputery odpowiedni program, który uruchamia się w czasie gdy komputer nie jest wykorzystywany i wykonuje zadania zlecone przez system zarządzający. W największych takich projektach biorą udział setki tysięcy ochotników, tworząc wirtualne superkomputery przewyższające wydajnością największe pojedyncze maszyny. Największe takie projekty to:

- Bitcoin – kryptowaluta Bitcoin może być generowana (ang. mining) na komputerach użytkowników poprzez uruchomienie specjalnego algorytmu. Od 2013 roku większość nowych bitcoinów jest generowana za pomocą wyspecjalizowanych układów ASIC, które nie mogą realizować żadnego innego algorytmu. Dlatego choć moc obliczeniowa sieci bitcoinów jest szacowana na ponad 1 zettaflops[24], to nie przekłada się to na żadne inne zastosowania. Szacując jednak że większość używanych układów ma wydajność energetyczną rzędu 100–1000 megahash/J[25], a cała sieć generuje ponad 100 petahash/s, sieć bitcoin musi mieć zapotrzebowanie mocy rzędu 100–1000 megawatów. Jest to więc projekt większy od największych superkomputerów.

- Folding@home – projekt badania procesów zwijania białek. W 2014 roku dysponował mocą ponad 40 PFLOPS[26] i jest odnotowany w Księdze Guinnessa jako największy klaster komputerowy na świecie[27].

- BOINC – projekt łączący komputery do różnych obliczeń, zapoczątkowany przez projekt SETI@home. Pracuje równolegle nad kilkudziesięcioma niezależnymi zagadnieniami. Sumaryczna moc obliczeniowa jaką dysponuje, to ponad 110 PFLOPS[28].

- GIMPS – projekt poszukiwania liczb Mersenne’a. Dysponuje mocą obliczeniową 190 TFLOPS[29].

- Distributed.net – projekt obliczeń teorioliczbowych, w szczególności badania możliwości łamania współczesnych szyfrów blokowych.

Farmy serwerów i botnety

Farma serwerów to zbiór luźno powiązanych ze sobą serwerów, współpracujących w celu realizacji jednego zadania. Stosuje się je w różnorodnych zastosowaniach komercyjnych, takich jak wyświetlanie spersonalizowanych stron w wyszukiwarkach internetowych i serwisach społecznościowych, czy rendering filmów 3D. Moc obliczeniowa takich farm może znacznie przewyższać moce obliczeniowe największych superkomputerów. Google i Microsoft posiadają setki tysięcy serwerów[30], których łączna moc obliczeniowa jest szacowana na dziesiątki PFLOPS[31]. Również największe botnety mają większą moc obliczeniową niż liderzy TOP500 (np. Storm botnet składający się z 1,9 mln komputerów[32]).

Systemy dedykowane

Na liście TOP500 umieszczone są jedynie komputery ogólnego zastosowania, na których można efektywnie wykonywać testy LINPACK. Do konkretnych zastosowań buduje się jednak czasem urządzenia dedykowane, efektywne w rozwiązywaniu tylko jednego, wybranego problemu. Pozwala to uzyskać większą efektywność i zmniejszyć koszty, za cenę uniwersalności. Przykładem takich urządzeń są:

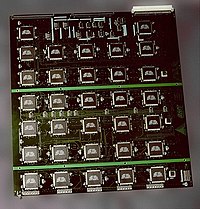

- EFF DES cracker[33] wybudowany w 1998 roku do łamania szyfrów DES.

- MDGRAPE-3 (2006)[34] i Anton (2008)[35][36] – do symulacji dynamiki molekularnej.

Zobacz też

Uwagi

- ↑ Pierwsze komputery wykonywały tylko operacje na liczbach całkowitych, dlatego ich szybkość podana jest w operacjach na sekundę (OPS). Współcześnie jednak znaczna większość zastosowań superkomputerów wymaga wykonywania operacji na liczbach zmiennoprzecinkowych, dlatego porównuje się je używając miary FLOPS. Nie ma oczywistego przelicznika pomiędzy tymi miarami, choć każda operacja zmiennoprzecinkowa może w szczególności być użyta jako całkowitoliczbowa.

- ↑ Koszt budowy komputera Tianhe-1A wyniósł około 88 milionów dolarów, podczas gdy inwestycje w zaprojektowanie i wdrożenie do produkcji procesorów Itanium 2 wyniosły 3 miliardy dolarów.

Przypisy

- ↑ New Japanese supercomputer is the world’s most powerful. geek.com, 20 czerwca 2011. [dostęp 2011-11-24]. [zarchiwizowane z tego adresu (5 grudnia 2011)].

- ↑ Mobile Linpack Results. 2020-06-13. [dostęp 2020-06-14]. (ang.).

- ↑ Najszybsze superkomputery świata w czerwcu 1993, miejsca 1-100. TOP500. (ang.).

- ↑ Dane na stronie Computer History Museum. Computerhistory.org. [dostęp 2010-10-31].

- ↑ a b Listy najszybszych superkomputerów w kolejnych latach na Top500.. Top500.org. [dostęp 2022-10-05].

- ↑ W 2006 roku twórcy MDGRAPE-3 ogłosili, że ma on moc 1 PFLOPS. Nie ma jednak niezależnego potwierdzenia tego faktu, ze względu na nieprzeprowadzenie testu LINPAC.

- ↑ El Capitan Supercomputer Detailed: AMD CPUs & GPUs To Drive 2 Exaflops of Compute, www.anandtech.com [dostęp 2020-03-13].

- ↑ USA budują najmocniejszy superkomputer - Altair Agencja Lotnicza, www.altair.com.pl [dostęp 2020-03-13] (ang.).

- ↑ Performance Development. Top500 Supercomputer Site. [dostęp 2018-06-09]. (ang.).

- ↑ Patrick Thibodeau: IBM breaks petaflop barrier. infoworld.com, 10 czerwca 2008. [dostęp 2016-05-21].

- ↑ IDF: Intel says Moore’s Law holds until 2029. [w:] Heise Online [on-line]. The H, 4 kwietnia 2008. [dostęp 9 września 2011-09-09]. [zarchiwizowane z tego adresu (2013-12-08)]. (ang.).zły zapis daty dostępu

- ↑ Tiffany Trader: IDC: Supercomputing Spending Jumps 30 Percent. HPC Wire, 25 marca 2013. [dostęp 2013-03-26]. [zarchiwizowane z tego adresu (2013-09-17)]. (ang.).

- ↑ China Makes World’s Fastest Supercomputer. International Business Times, 28 października 2010. [dostęp 2011-09-09]. (ang.).

- ↑ Intel strengthens investment in Intel Itanium architecture with hiring of HP design team. 16 grudnia 2004. [dostęp 2011-09-09]. (ang.).

- ↑ Otwarte granty ICM. Interdyscyplinarne Centrum Modelowania Matematycznego i Komputerowego Uniwersytetu Warszawskiego. [dostęp 2011-09-09]. [zarchiwizowane z tego adresu (2014-07-14)].

- ↑ The Problem with Cellulosic Ethanol. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ Simulating Turbulent Combustion Speeds Design of Power and Propulsion Devices. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ Boeing Uses Jaguar to Validate Aircraft Modeling Applications. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ BMI Uses Jaguar to Overhaul Long-Haul Trucks. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ Breakthrough Fusion Simulations Shed Light on Plasma Confinement. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ Supercomputers Aid in Understanding the Basic Building Blocks of Nature. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ Packing the ions. Oak Ridge National Laboratory. [dostęp 2011-11-08]. (ang.).

- ↑ Gordon Bell Prize Awarded to Research Group Using K Supercomputer. HPC wire, 21 listopada 2011. [dostęp 2011-11-24]. [zarchiwizowane z tego adresu (25 listopada 2011)]. (ang.).

- ↑ Bitcoin Network. [dostęp 2014-07-02]. (ang.).

- ↑ Mining hardware comparison. [dostęp 2014-07-02]. (ang.).

- ↑ Folding@home – The Science. [dostęp 2014-12-10]. [zarchiwizowane z tego adresu (6 stycznia 2016)]. (ang.).

- ↑ Joshua Topolsky: Folding@Home recognized by Guinness World Records. Engadget, 31 października 2007. [dostęp 2011-09-09]. (ang.).

- ↑ Statystyki BOINC. [dostęp 2014-12-10]. (ang.).

- ↑ Strona domowa projektu GIMPS. [dostęp 2014-12-10]. (ang.).

- ↑ Rich Miller: Who Has the Most Web Servers?. Data Center Knowledge, 14 maja 2009. [dostęp 2011-09-09]. (ang.).

- ↑ Brough Turner: Google Surpasses Supercomputer Community, Unnoticed?. 20 maja 2009. [dostęp 2011-09-09]. [zarchiwizowane z tego adresu (22 października 2011)]. (ang.).

- ↑ Gaudin, Sharon. „Storm Worm Botnet Attacks Anti-Spam Firms”, InformationWeek, 18 września 2007.

- ↑ „DES Cracker” Machine. Electronic Frontier Foundation. [dostęp 2011-09-09]. [zarchiwizowane z tego adresu (2011-08-30)]. (ang.).

- ↑ Tetsu Narumi: MDGRAPE (Molecular Dynamics GRAvity PipE). 31 października 2006. [dostęp 2011-09-09]. [zarchiwizowane z tego adresu (13 lutego 2008)]. (ang.).

- ↑ John Markoff: Herculean Device for Molecular Mysteries. The New York Times, 8 lipca 2008. [dostęp 2011-09-09]. (ang.).

- ↑ Mariusz Błoński: Superkomputer Anton – mistrz zaginania białek. KopalniaWiedzy, 18 października 2010. [dostęp 2011-09-09].

Media użyte na tej stronie

Autor: AI.Graphic, Licencja: CC BY-SA 3.0

Wykładniczy wzrost mocy obliczeniowej superkomputerów, na podstawie danych ze strony top500.org. Na osi Y pokazana jest moc obliczeniowa w GFLOPS w skali logarytmicznej

Autor: Joseph Coffland, Licencja: CC0

Folding@home banner logo, created by Joseph Coffland (Folding@home developer) 2012

Autor:

Oryginalnym przesyłającym był Matt Crypto z angielskiej Wikipedii

Later versions were uploaded by Ed g2s at en.wikipedia., Licencja: CC BY 3.0 usDES Cracker circuit board fitted with Deep Crack chips

- Source: http://w2.eff.org/Privacy/Crypto/Crypto_misc/DESCracker/

- Copyright: the Electronic Frontier Foundation.

- Information on licenses found from: https://www.eff.org/ ; private communication by en:User:Matt Crypto

Autor: Argonne National Laboratory's Flickr page, Licencja: CC BY-SA 2.0

The IBM Blue Gene/P supercomputer installation at the Argonne Leadership Angela Yang Computing Facility located in the Argonne National Laboratory, in Lemont, Illinois, USA.

Autor: OLCF at ORNL, Licencja: CC BY 2.0

The U.S. Department of Energy’s Oak Ridge National Laboratory unveiled Summit as the world’s most powerful and smartest scientific supercomputer on June 8, 2018.

With a peak performance of 200,000 trillion calculations per second—or 200 petaflops, Summit will be eight times more powerful than ORNL’s previous top-ranked system, Titan. For certain scientific applications, Summit will also be capable of more than three billion billion mixed precision calculations per second, or 3.3 exaops. Summit will provide unprecedented computing power for research in energy, advanced materials and artificial intelligence (AI), among other domains, enabling scientific discoveries that were previously impractical or impossible.Autor: Michal Krakowiak, Licencja: CC-BY-SA-3.0

The new Berkeley Open Infrastructure for Network Computing (BOINC) logo.

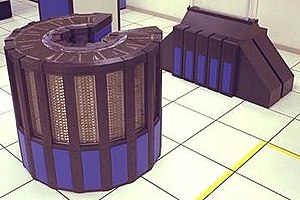

Control Data 6600 mainframe - Exposition - Grande Arche - Paris

Cray 2, serial number 2013 with Static RAM [SRAM] and water fall style heat exchanger/reservoir